Un algorithme qui prend 1 seconde pour 1000 données mais 11 jours pour 1 million ? Bienvenue dans l'univers fascinant de la complexité algorithmique. Autant vous prévenir : l’ignorer est sans doute l’erreur la plus coûteuse que puisse commettre un développeur. La complexité est un levier essentiel pour garantir que votre code reste performant à mesure que vos données augmentent. Et donc qu’il ne plombe pas vos performances, vos coûts — et in fine votre business tout entier. Voici un guide complet pour tout comprendre : 1) Pourquoi la complexité algorithmique est incontournable ; 2) Les 7 classes de complexité à connaître ; 3) Comment évaluer la complexité de vos algorithmes ; 4) Des exemples concrets d'algorithmes célèbres ; 5) Les bonnes pratiques pour maîtriser la complexité ; 6) Les mythes et limites souvent négligés. Avec des exemples concrets, des analogies mémotechniques, une méthode clé-en-main et des astuces inédites. Préparez-vous à sauver les performances de vos projets (et à briller en réunion).

Complexité d’un algorithme : la réponse courte pour briller en réunion

Définition express : complexité temporelle vs spatiale

La complexité temporelle mesure le nombre d’opérations qu’un algorithme effectue selon la taille de l’entrée (n). La complexité spatiale, elle, compte la quantité de mémoire supplémentaire requise pendant l’exécution. Donald Knuth a formalisé tout ça, histoire d’éviter les débats stériles à la machine à café.

Prenons une boucle for sur un tableau de n éléments : temps = O(n), car chaque élément est visité; espace = O(1), car on ne stocke rien de plus qu’un index. Autant vous dire que confondre les deux, c’est comme croire que RAM et CPU sont interchangeables !

- Permet de choisir la bonne structure selon les contraintes matériel/stockage

- Évite de coder un gouffre mémoire là où un bug performant aurait suffi

La notation Big O en une ligne – et pourquoi elle fait loi

Formule canonique : f(n) = O(g(n)) ⇔ ∃ C, n₀ ; ∀ n ≥ n₀, f(n) ≤ C·g(n).

Big O décrit l’ordre de grandeur asymptotique : on regarde comment le temps (ou l’espace) évolue quand la taille des données explose. En jargon d’initié ? C’est l’analyse asymptotique qui pose les bornes supérieures du pire cas, indifférente aux détails minables du matériel ou du langage.

« L’analyse asymptotique permet d’anticiper les comportements pathologiques des algorithmes bien avant qu’ils ne plantent en production. » — Knuth (paraphrasé)

Pourquoi la complexité algorithmique peut sauver (ou flinguer) votre projet ?

Impact direct sur les performances temps réel et l’expérience utilisateur

Vous pensez que la complexité, c’est pour les matheux qui font peur pendant le café ? Raté. La complexité temporelle conditionne directement la réactivité des applis. Exemple vécu : une app mobile qui fait du O(n²) quand vous scrollez un feed, résultat ? L’écran freeze, le CPU chauffe, l’utilisateur peste… et part chez le concurrent en deux clics. Le pire, c’est que ces lenteurs arrivent pile dans le "pire cas", celui que personne ne veut voir mais que tout le monde finit par subir en prod.

Conséquences budgétaires : coûts hardware, cloud et empreinte carbone

Le cloud n'est pas infini ! La complexité spatiale peut rapidement se traduire par des coûts élevés. Un algo O(n²), c’est plus qu’un gouffre mémoire : c’est du CPU cramé, du RAM surdimensionné et une empreinte carbone qui ferait rougir un data center chinois.

| Volume de données | O(n) RAM estimée | O(n²) RAM estimée | Coût mensuel AWS (approx.) |

|---|---|---|---|

| 1 000 | 1 Mo | 2 Mo | 0.30 € |

| 10 000 | 10 Mo | 100 Mo | 2 € |

| 100 000 | 100 Mo | ~1 Go | >20 € |

| 1 million | ~1 Go | ~100 Go (!!) | >150 € |

Les choix de complexité ont des répercussions concrètes sur votre budget et sur l'empreinte écologique de vos projets.

Quand ignorer la complexité devient un risque business majeur

Par expérience (et là, c’est le drame), ignorer la complexité algorithmique finit toujours par coûter cher. Quelques risques concrets :

- Surcoût matériel ou cloud imprévu (et non budgétisé)

- Perte d’utilisateurs à cause de lenteurs ou bugs récurrents

- Dette technique qui enfle jusqu’à la refonte forcée (aka "projet reboot")

- Downtime lors des pics de charge ou migration de données

- Retards projet irrattrapables à force d’empiler patches et bricolages

Les 7 classes de complexité à connaître par cœur (et leurs analogies mémo-techniques)

O(1) : constante – le graal du dev paresseux

O(1), c’est l’éden algorithmique. L’exécution ne bouge jamais, même si vous injectez un million d’entrées. Exemple ultime : accéder à une valeur dans une table de hachage (lookup clé → valeur). Le temps reste plat comme le cerveau d’un stagiaire après 36h sans dormir. Autre image ? Chauffer son café au micro-onde : que vous réchauffiez un espresso ou toute la cafetière, c’est pareil – l’action prend toujours le même temps (hors bug matériel évidemment!).

O(log n) : logarithmique – la recherche dichotomique sans détour

O(log n), c’est la gymnastique cérébrale qui rend les algos sexy. La recherche dichotomique (ou binaire) est l’icône du genre : diviser pour régner, répéter jusqu’à tomber pile sur la cible. Imaginez un yoga asymptotique où vous pliez les données en deux à chaque respiration — oui, ça fait du bien aux CPU ! Pour chaque doublement de masse de données, il ne faut qu’une seule étape de plus.

O(n) : linéaire – le brute force qui se cache sous le tapis

Le parcours linéaire O(n), c’est l’algorithme du feignant assumé : on scanne tout, sans finesse. Chercher une valeur dans un tableau non trié ? Du début à la fin, pas de secret. Ça passe à l’école — ça casse en prod. Croire qu’on peut s’en tirer avec du linéaire partout, c’est garantir des lenteurs dès que les volumes décollent.

O(n log n) : quasi-linéaire – tri efficace, ego apaisé

Tri rapide (quicksort), tri fusion : ces classiques atteignent O(n log n) dans la vraie vie (hors pire cas sadique). Parfait pour trier des millions d’entrées sans sacrifier votre dignité technique ni votre facture cloud. Si Knuth a consacré des chapitres entiers à ce type dans "The Art of Computer Programming", ce n’est pas juste pour briller en conf’, mais parce qu’il sauve des journées entières et des serveurs.

O(n²) / O(n³) : quadratique et cubique – l’enfer du junior distrait

Double boucle imbriquée ? Bienvenue en quadratique (O(n²)) ! Triple boucle ? Cubique (O(n³)), et là… autant enterrer votre ticket JIRA tout de suite. La croissance est féroce : Formule de Stirling oblige, même pour n = 1000 ça devient grotesque en ressources. Anecdote vécue : une startup a explosé son budget AWS sur un simple bout de code naïf oublié au fond d’un microservice (!).

O(2ⁿ) : exponentielle – quand votre PC prend feu

Problème du voyageur ? Complexité O(2ⁿ) typique ! Là on tape dans la catégorie "départ feu de forêt sur CPU" — chaque ajout d’entrée double les besoins en calculs. Même Google n’a pas assez d’électricité pour supporter ce délire longtemps.

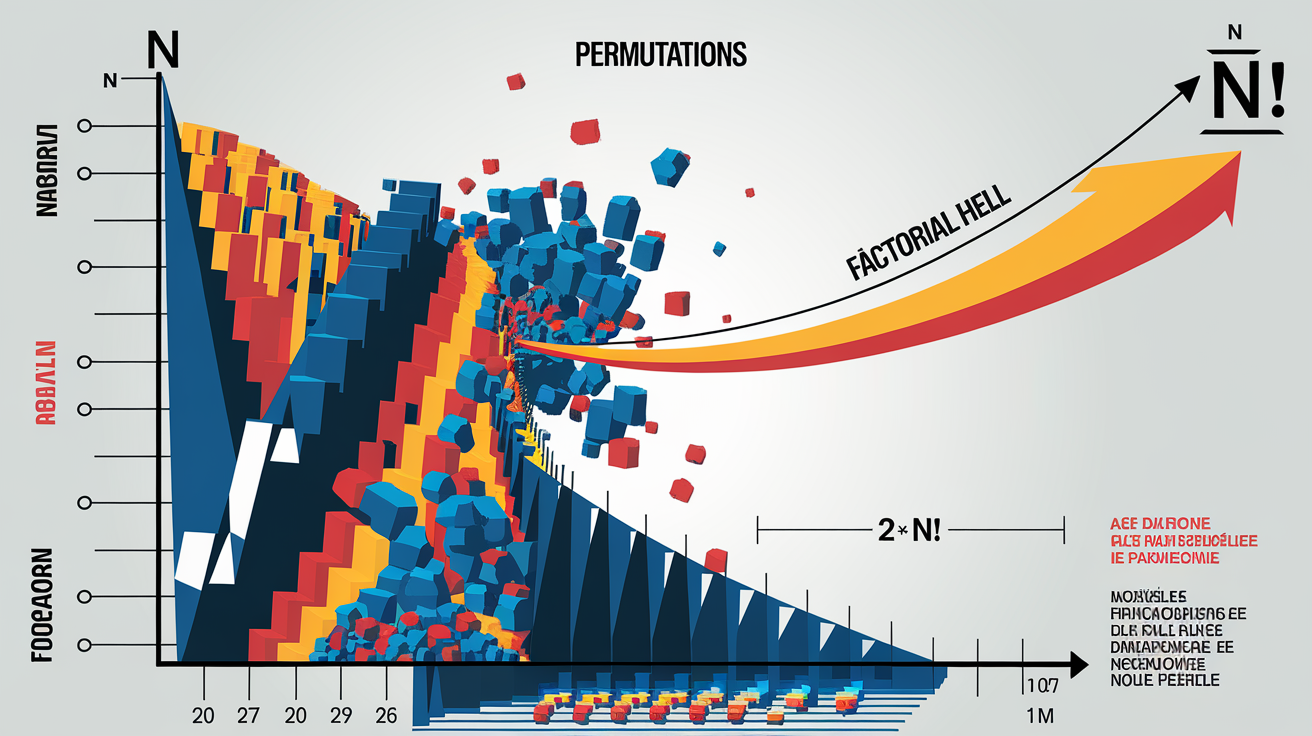

O(n!) : factorielle – le cauchemar absolu des combinatoires

Permutation brute-force = O(n!), soit le piège à mouche infinie : impossible d’en sortir vivant dès que n > 10. Calculer toutes les possibilités ? La courbe explose si violemment que même l’exponentielle fait pâle figure à côté !

Retenez bien : mal choisir sa classe de complexité revient à programmer sa propre mise au chômage… ou celle de ses serveurs.

Bonnes pratiques pour dompter la complexité dès la conception

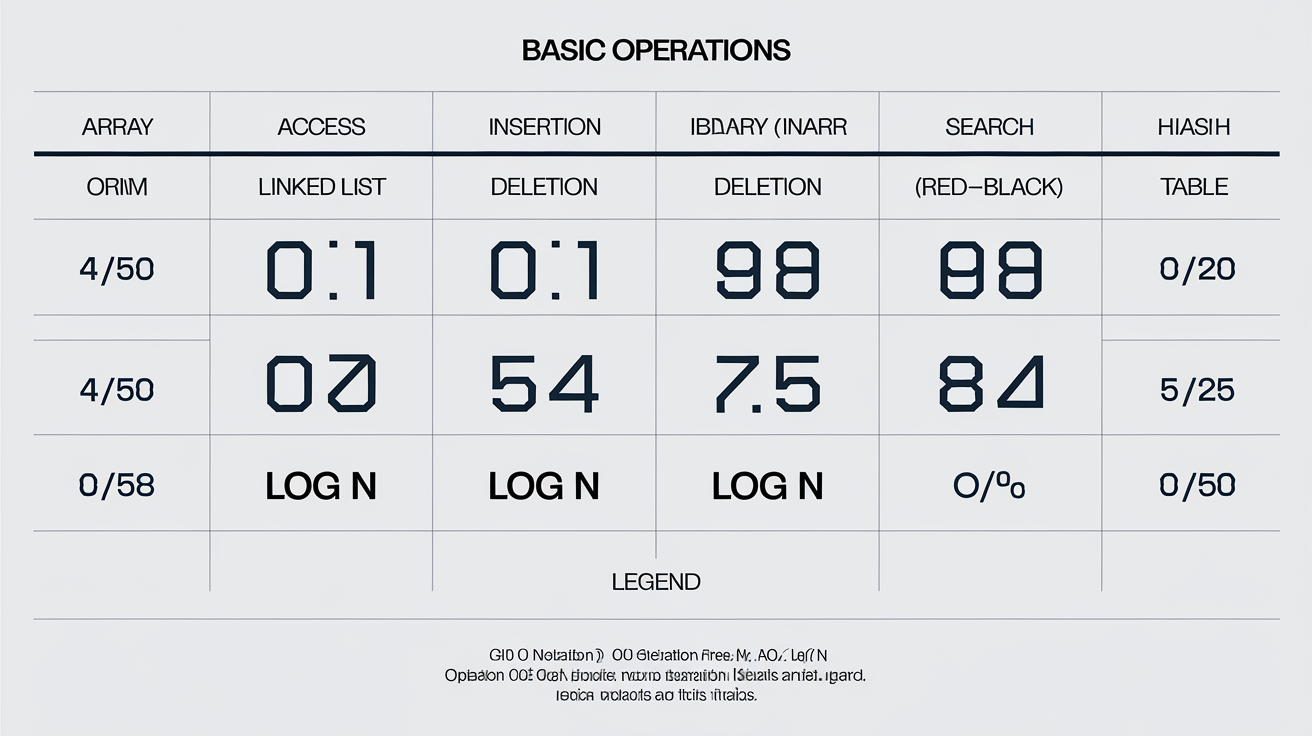

Choisir la bonne structure de données : tableaux, listes, arbres, hachages

Pour éviter de finir dans les limbes de la latence, il faut matcher l’opération dominante avec la structure adaptée. Oubliez les tableaux dynamiques pour les recherches fréquentes ou le hachage pour tout ce qui doit conserver l’ordre !

Décidez en deux secondes : quelle structure pour quel usage ?

- Lecture rapide à une position connue ? → Tableau (O(1) accès)

- Ajout/suppression en tête ? → Liste chaînée (O(1))

- Insertion/suppression ordonnée ? → Arbre AVL / Red-Black (O(log n))

- Recherche par clé unique ? → Table de hachage (O(1) si pas trop d’abrutis sur les hashs)

- Besoin d’ordre ET vitesse ? → Arbres équilibrés

Checklist éclair :

- [ ] Identifier opérations critiques (accès, ajout, suppression)

- [ ] Prioriser l’ordre ou la rapidité brute?

- [ ] Prendre en compte le taux de collision potentiel sur hash

- [ ] Vérifier le support natif du langage ciblé (certains arbres sont pénibles à coder manuellement)

Optimiser la mémoire sans se tirer une balle dans le pied

Il ne suffit pas d’empiler les Go de RAM pour bien coder. La mémoire vive sert à l’exécution immédiate, la mémoire de masse stocke « au repos » – confondre les deux, c’est digne d’un amateur.

Les vrais cracks pensent cache alignment : alignez vos structures sur les frontières des lignes de cache processeur pour éviter des ralentissements monstrueux (voir Number Analytics). Rajouter des octets de padding n’est pas une hérésie si ça évite des cache misses récurrents. Parfois on sature la RAM… juste parce qu’on a mal agencé ses structs.

Astuces rarement avouées :

* Grouper les champs accédés ensemble dans vos structs/classes.

* Favoriser l’accès séquentiel aux données plutôt que scatter/gather — le CPU adore ça.

* Éviter d’allouer dynamiquement au moindre accès : pensez pool mémoire.

* Ne jamais ignorer les outils de profilage mémoire — même un vieux Valgrind peut vous sauver une nuit blanche.

Patterns de refactorisation anti-O(n²) que personne n’enseigne

Les cours théoriques dénoncent souvent O(n²), mais concrètement, peu expliquent comment transformer une double boucle en algo linéaire. Le secret ? Pré-indexation et memoization valident OnlyFans du dev malin !

Cas concret : rechercher rapidement la fréquence d’un élément dans un tableau géant.

Mauvais réflexe : double boucle imbriquée = O(n²), catastrosphe annoncée.

Solution radicale : utilisez un dictionnaire pour compter chaque valeur lors d’une seule passe (O(n)). Ensuite, chaque requête est instantanée. Partitionner le problème en lots indépendants casse aussi la croissance quadratique — faites tourner vos batchs en parallèle si possible !

« Un code qu’on ne refactore JAMAIS finit toujours par coûter plus cher que prévu – parole d’ancien mauvais élève »

Limites et mythes autour de la complexité : ce que les slides de conf oublient

Influence du matériel, du compilateur et du langage

Croire que le Big O « gomme » les différences matérielles, c’est mal connaître la réalité des octets. Oui, un CPU plus rapide accélère tout — mais dans la même proportion. Un algo foireux reste foireux sur une machine survitaminée. Par contre, le choix du langage et la qualité du compilateur font exploser les chronos (et pas en bien !). Testez une recherche linéaire sur 10⁶ entrées : Python s’effondre face à C++, même si l’algo est identique sur le papier. Pourquoi ? Gestion mémoire manuelle en C++, optimisations natives, surcoût de l’interprétation Python…

Exemple concret : un batch nocturne réduit de 2h à 7 minutes après migration d’un script Python vers C++, sans modifier l'algorithme. Nier l’influence du matos ou des couches logicielles, c’est coder avec des œillères.

Mesures empiriques versus modèles théoriques

Le Big O brille à la fac, mais en prod ? Les benchmarks empiriques déterrent les faiblesses cachées dans les coins sombres : allocation mémoire sauvage, cache CPU saturé, latence réseau…

Bref : la vérité se niche entre la théorie (utile pour prévoir l’avenir) et l’expérience terrain (impitoyable juge des ratés d’optimisation). Ne faites confiance ni aux slides ni aux benchs seuls ; il faut croiser systématiquement.

Ces cas où une complexité élevée reste acceptable (et pourquoi)

La chasse au O(1) systématique est ridicule dans certains contextes. Un algorithme exponentiel ou factoriel ? Parfois c’est le compromis optimal… à condition que le volume traité soit microscopique (n ≤ 12), ou que l’exécution soit unique (exemple : script de déploiement système lancé une fois par trimestre).

Les experts qui prétendent bannir toute complexité élevée oublient cette réalité : tant que votre « run » dure moins qu’une pause clope, et ne sature pas le cloud à chaque exécution, ça passe crème. Moralité ? Tout dépend du contexte d’usage – sortez des dogmes.

Checklist anti-complexité

Avant d’appuyer sur "merge" comme un automate et de partir boire votre café, prenez 30 secondes pour passer ce contrôle minimal — histoire d’éviter le ridicule (et la honte en prod). Go commit, not go cry !

- Analyse Big O vérifiée : savez-vous vraiment dans quelle classe tombe votre algo (O(1), O(n), O(n²), etc.) ? Pas de flou accepté !

- Empreinte mémoire passée au crible : l’algo ne fait pas exploser la RAM ni stocker des données inutiles sous prétexte que « c’est le cloud ».

- Benchmarks terrain effectués : chrono sur dataset réel pour éviter les surprises avec des constantes cachées ou un compilateur facétieux.

- Structures de données optimisées : pas de tableau là où un hachage ou un arbre équilibré ferait gagner un facteur x10.

- Refactorisation anti-nesting : toute imbrication douteuse (double boucle ?) a été challengée, memoization ou autre astuce tentée.

Déjà coché tout ça ? Alors faites tourner le build… sinon, préparez les mouchoirs.